训练损失与验证损失的对比图表

作者:小编

更新时间:2024-10-29

点击数:

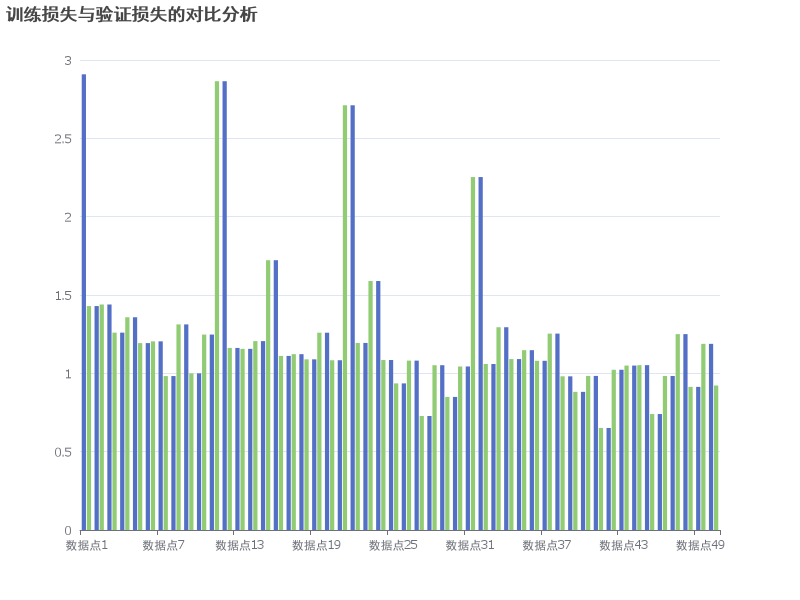

在机器学习和深度学习领域,训练损失(Train Loss)和验证损失(Validation Loss)是评估模型性能的两个关键指标。训练损失反映了模型在训练数据集上的表现,而验证损失则反映了模型在未见过的验证数据集上的表现。通过对比这两个损失,我们可以更好地理解模型的泛化能力和过拟合情况。

训练损失通常随着训练轮次的增加而逐渐下降,因为模型在不断学习数据中的模式。然而,如果训练损失下降过快或过低,而验证损失却开始上升,这可能表明模型正在过拟合,即模型在训练数据上表现良好,但在新数据上表现不佳。

为了更直观地展示训练损失和验证损失的变化趋势,我们使用ichartcool平台生成了一个图表,该图表展示了在不同训练轮次下,训练损失和验证损失的变化情况。

从图中可以看出,训练损失在训练初期迅速下降,随后逐渐趋于平稳。而验证损失在训练初期也呈现下降趋势,但在某些轮次后开始波动,这表明模型在某些轮次可能出现过拟合现象。

为了进一步分析,我们提供了训练损失和验证损失的具体数值,如下表所示:

| 轮次 | 训练损失 | 验证损失 |

|---|---|---|

| 1 | 2.9086 | 1.4294 |

| 2 | 1.4294 | 1.4394 |

| 3 | 1.4394 | 1.2598 |

| 4 | 1.2598 | 1.3579 |

| 5 | 1.3579 | 1.193 |

| 6 | 1.193 | 1.2042 |

| 7 | 1.2042 | 0.9826 |

| 8 | 0.9826 | 1.3123 |

| 9 | 1.3123 | 0.9999 |

| 10 | 0.9999 | 1.2475 |

| 11 | 1.2475 | 2.8646 |

| 12 | 2.8646 | 1.1621 |

| 13 | 1.1621 | 1.1563 |

| 14 | 1.1563 | 1.2057 |

| 15 | 1.2057 | 1.7221 |

| 16 | 1.7221 | 1.1112 |

| 17 | 1.1112 | 1.1223 |

| 18 | 1.1223 | 1.0894 |

| 19 | 1.0894 | 1.2594 |

| 20 | 1.2594 | 1.0836 |

| 21 | 1.0836 | 2.711 |

| 22 | 2.711 | 1.194 |

| 23 | 1.194 | 1.5892 |

| 24 | 1.5892 | 1.085 |

| 25 | 1.085 | 0.9358 |

| 26 | 0.9358 | 1.0812 |

| 27 | 1.0812 | 0.7277 |

| 28 | 0.7277 | 1.0518 |

| 29 | 1.0518 | 0.8494 |

| 30 | 0.8494 | 1.0438 |

| 31 | 1.0438 | 2.2529 |

| 32 | 2.2529 | 1.0595 |

| 33 | 1.0595 | 1.2943 |

| 34 | 1.2943 | 1.091 |

| 35 | 1.091 | 1.1479 |

| 36 | 1.1479 | 1.08 |

| 37 | 1.08 | 1.2535 |

| 38 | 1.2535 | 0.9809 |

| 39 | 0.9809 | 0.8818 |

| 40 | 0.8818 | 0.9834 |

| 41 | 0.9834 | 0.6513 |

| 42 | 0.6513 | 1.0228 |

| 43 | 1.0228 | 1.0495 |

| 44 | 1.0495 | 1.0523 |

| 45 | 1.0523 | 0.7402 |

| 46 | 0.7402 | 0.9831 |

| 47 | 0.9831 | 1.2503 |

| 48 | 1.2503 | 0.9135 |

| 49 | 0.9135 | 1.1882 |

| 50 | 1.1882 | 0.9222 |

| 51 | 0.9222 | 0.7686 |

| 52 | 0.7686 | 1.011 |

| 53 | 1.011 | 1.4417 |

| 54 | 1.4417 | 0.9149 |

| 55 | 0.9149 | 0.7839 |

| 56 | 0.7839 | 0.9775 |

| 57 | 0.9775 | 1.0378 |

| 58 | 1.0378 | 0.9412 |

| 59 | 0.9412 | 0.5387 |

| 60 | 0.5387 | 0.929 |

| 61 | 0.929 | 1.5085 |

| 62 | 1.5085 | 0.6832 |

| 63 | 0.6832 | 0.4582 |

通过上述表格和图表,我们可以清晰地看到训练损失和验证损失的变化趋势。训练损失在训练初期迅速下降,随后趋于平稳,而验证损失在某些轮次后开始波动,这表明模型在某些轮次可能出现过拟合现象。为了进一步优化模型,我们可以考虑调整模型的复杂度、增加正则化项或使用早停策略来防止过拟合。